Ein paar Tausend Bücher können zwei Augen während ihres Lebens durchdringen. Hunderttausende Bücher schaffen die Algorithmen Digitaler Geisteswissenschaftler. Fotis Jannidis – Professor für Computerphilologie und Neuer Deutsche Literaturgeschichte an der Universität Würzburg – verrät uns, wie digitale Methoden die Literaturwissenschaft bereichern können.

Für alle, die keine Zeit zum Zuhören haben oder sich einfach einen Überblick über das Gespräch wünschen, haben wir hier die wichtigsten Thesen und Hintergrundinfos zusammengetragen.

Thesen |

Thesen |  Tipps für Studenten |

Tipps für Studenten |  Hintergrundinfos

Hintergrundinfos

Thesen

Literaturwissenschaft und Computerphilologie

- In den Nullerjahren erlebte die digitale Textanalyse einen rasanten Aufschwung. Während der vergangenen 15–20 Jahre wurde eine große Datenmenge verfügbar gemacht – infolge von Digitalisierungsbemühungen der Bibliotheken auch literarische Texte bzw. Korpora. Hierdurch wurde die Etablierung maschineller Lernverfahren ermöglicht.

- Digitale Methoden können die literaturwissenschaftliche Einzeltextanalyse nicht ersetzen: Innerhalb der Literaturwissenschaft wurde ein komplexer Apparat an Textbeobachtungsmechanismen aufgebaut. Hierdurch wurden Aussagen über ästhetische Strukturen, Erzählperspektiven etc. möglich, die (noch?) nicht formalisierbar und daher nicht maschinell durchführbar sind.

- Die Frage, wie sich ein Einzeltext zu anderen Texten verhält, leitet jedoch über zu quantitativen Analysen – beispielsweise kann ein Text zu anderen Texten aus dieser Zeit statistisch ins Verhältnis gesetzt werden. Die Literaturwissenschaft hat also immer eine doppelte Aufgabe: Einerseits versucht sie, in die Gesellschaft hineinzuwirken und ein Bewusstsein für ästhetische Strukturen zu vermitteln, andererseits ist die Literaturwissenschaft ein historisches Fach, das u.a. ästhetische Strukturen mit empirischen Methoden – mit Überprüfungsverfahren – sichtbar macht. Die Computerphilologie schließt hier an, indem sie bspw. historische Analysen über mehrere Texte hinweg möglich macht.

- Der Blick der Computerphilologie ist noch immer eher ’schlicht‘, da die Formalisierungsverfahren noch oberflächlich sind. In absehbarer Zeit wird es daher wohl noch keine ‚lesenden Maschinen‘ geben. Die noch junge Fachdisziplin arbeitet daran, die Analyseverfahren zu verfeinern. Was geleistet werden kann, ist jedoch die Beantwortung von Fragen, die viele Texte betreffen: beispielsweise nach der Anzahl männlicher und weiblicher Hauptfiguren in erzählenden Texten zu einer bestimmten Zeit oder nach Mustern in Sentiment-Verläufen.

Methodik

- Das ‚organische‘ Lesen unterscheidet sich grundlegend vom ‚maschinellen‘ Einzelblick. Während der bzw. die LeserIn während der Lektüre zahlreiche Informationen gleichzeitig wahrnehmen kann, kann sich die digitale Textanalyse immer nur auf eine einzige Sache konzentrieren – daher muss vorher genau festgelegt werden, was untersucht werden soll.

- Umgekehrt ist es möglich, noch nicht genau zu wissen, wonach man sucht – und trotzdem zu Ergebnissen zu kommen: Dazu kann zuerst eine Exploration in Form einer sehr allgemeinen quantitativen Textanalyse durchgeführt werden, die dann als Grundlage der Hypothesenbildung dient (‚Grounded Theory‘).

- Der Großteil der DH-Verfahren wird derzeit aus der Computerlinguistik und Informatik übernommen, so zum Beispiel auch das Topic Modeling, das in der Informatik entwickelt worden ist. Aufgrund der disziplinären bzw. methodischen Unterschiede – so erfolgt die Softwareentwicklung meist auf Grundlage von Zeitungskorpora – müssen die Methoden vor ihrer Anwendung auf literaturwissenschaftliche Fragestellungen bzw. Daten kritisch geprüft werden.

- Digital Humanities sind ein eigenes (interdisziplinäres) Fach wie die Bio- oder Wirtschaftsinformatik – und nicht nur ein Werkzeugkoffer.

- Was sind Digital Humanists? Es sind im weitesten Sinne Personen, die digitale Ressourcen verwenden oder digitale Verfahren anwenden. In einem engeren Sinne sind es Personen, die digitale Ressourcen entwickeln und digitale Methoden weiterentwickeln, die also neue Verfahren aus der Informatik sichten, selektieren, deren Anwendbarkeit auf geisteswissenschaftliche Materialien vorstellen und die gewählten Verfahren parametrisieren. Das enger gefasste Fach ist jedoch heute noch nicht trennscharf von dem breiteren Verständnis abzugrenzen.

- Eine langfristige Methodenentwicklung ist notwendig, um Werkzeuge überhaupt auswählen und auf Teilprobleme anwenden zu können. Das Versprechen, mit nur wenigen technischen Tricks schnelle Erfolge zu erzielen, ist verfehlt.

- Wir müssen über Ethik reden. Maschinelles Lernen und Deep Learning sind Waffen, die insbesondere außerhalb des Wissenschaftsbereichs Schäden verursachen können. Zum einen bleiben nicht alle Studierenden in der Wissenschaft. Wissen wandert ab in andere Bereiche und Know-how kann mitgenommen werden. Ob Racial oder Gender Biases – Erkenntnisse aus der Textanalyse können auch auf hochsensible Korpora wie beispielsweise Bewerbungsunterlagen angewendet werden. Auch Fragen wie „Hat dieser Blogger diesen Text geschrieben?“ lassen sich mit Wahrscheinlichkeitswerten beantworten. Was für die freie Wissenschaft historisch spannend ist, kann in anderen Kontexten gefährlich werden. Zum anderen könnten auch Algorithmen, die wir heute entwickeln, in einem zukünftigen multimodalen System einer künstlichen Intelligenz durchaus Sprengkraft besitzen, die momentan noch nicht abzusehen ist.

Interdisziplinarität

- ComputerphilologInnen können Wissensbereiche verbinden. Sie können fachlich weder so breit bewandert sein wie ‚reine‘ Neuere Deutsche LiteraturwissenschaftlerInnen, noch können Sie als Vollinformatiker gelten. Ihre Stärke besteht jedoch im Zusammendenken komplexer Disziplinen. Sie sind in der Lage, selektiv und produktiv auf beide Bereiche zuzugreifen.

- Wir müssen nicht alle zu Informatikern werden. Bestimmte Architekturbelange sind genuine Aufgaben von Fachinformatikern, so beispielsweise der Aufbau leicht und gut benutzbarer Bibliotheken. Die Verwendung dieser Bibliotheken für die Datenanalyse ist jedoch kein Hexenwerk.

- Die Erzeugung und Bereitstellung digitaler Daten aus verschiedenen Bereichen führt langfristig zu einer Angleichung der Wissenschaften, denn plötzlich ist eine Zusammenarbeit mit Physikern, Marktforschern etc. möglich. Es ist das Verständnis von Wissenschaft als ‚Data Science‘. Zusätzlich zu den Fachkenntnissen der Einzelwissenschaften müssen also Statistik- und Informatikkenntnisse erworben werden, um den Reichtum der Untersuchungsinstrumente überhaupt nutzen zu können.

Tipps für Studierende

- Keine Angst vor Bits und Bytes! Auch Nicht-Informatiker können das Coden lernen. Entsprechende Unikurse oder Self-Learning-Tools bringen das nötige Basis-Know-how. Und vielleicht hat sich ja schon ein DH-Stammtisch an deinem Wohnort gegründet?

- Seid nett zueinander, denn Interdisziplinarität bedeutet Annäherung, Abbau von Vorurteilen und Austritt aus der eigenen Komfortzone. Die Gegenstände sowohl der GeisteswissenschaftlerInnen als auch der InformatikerInnen sind komplex, das Einfinden in den Bereich des jeweils anderen Faches ist zeitintensiv. Lässt man sich jedoch darauf ein, kann sich die Zusammenarbeit als umso produktiver gestalten.

- Scheue dich nicht, auch mal ein dickes Brett zu bohren. Zumindest prinzipielles Interesse an mathematischen Grundlagen kann nicht schaden …

- Finde zunächst heraus, wie die von dir genutzten Programme mit deinem Material zusammenspielen, wie sie funktionieren. Methodische Kenntnisse und Vortests sind unerlässlich, um gute Ergebnisse zu erzielen. Frage dich daher schon frühzeitig, wie du dein ‚Experiment‘ so aufbauen kannst, dass du am Ende eine Antwort auf deine Fragestellung erwarten kannst.

- Bleib aufmerksam! Insbesondere interdisziplinäres Arbeiten und der damit verbundene Rückgriff auf verschiedene Methoden erfordert stetige Aufmerksamkeit auf den Gesamtkontext.

- Unterscheide deutlich zwischen explorativer und hypothesengeleiteter Datenanalyse. Definiere vor jeder Untersuchung den Forschungsaufbau- bzw. das Forschungsdesign.

- Arbeite hart 😉. Die Digital Humanities sind eines der schönsten Forschungsfelder, die man im Augenblick haben kann. Man muss viel tun, doch es ist auch extrem befriedigend.

- Probiere einfach mal ein Konkordanz-Programm wie AntConc aus und experimentiere mit einer Textsammlung deiner eigenen Festplatte. Lege dir Metadaten an und analysiere sie doch einfach mal …

Hintergrundinfos

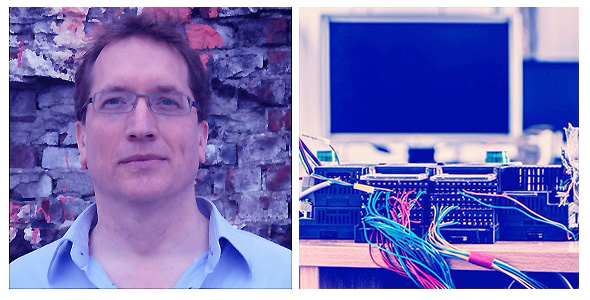

Prof. Dr. Fotis Jannidis

… ist Professor für Computerphilologie und Neuere Deutsche Literaturwissenschaft an der Universität Würzburg. Er ist Mitglied der Gesellschaft für Informatik. Seine Arbeitsschwerpunkte sind Computerphilologie, Stilometrie, die Literatur- und Erzähltheorie sowie die Geschichte des Romans.

Julius-Maximilians-Universität Würzburg

Die Universität Würzburg verfügt über den Lehrstuhl für Computerphilologie und Neuere Deutsche Literaturgeschichte, den Prof. Dr. Fotis Jannidis innehat. Digital Humanities können hier sowohl im Bachelor- als auch im Masterstudiengang studiert werden. Schwerpunkte sind u.a. Textcodierung und digitale Editionen.

Infos zur Universität Würzburg

Computerphilologie

Die Computerphilologie entstand in den 1980er Jahren als Parallelbildung zur Computerlinguistik. In der Computerphilologie werden Maschinen zur Klärung literaturwissenschaftlicher Fragestellungen verwendet. Dabei gliedert sich die Computerphilologie in zwei größere Teilbereiche auf: zum einen der Bereich der digitalen Editionen und Annotationen, zum anderen der Bereich der digitalen Textanalyse – also quantitative Textanalyse, Text Mining oder nach Franco Moretti „Distant Reading“.

Gesellschaft für Informatik e.V. (GI)

Die Gesellschaft für Informatik ist mit rund 20.000 persönlichen und 250 korporativen Mitgliedern die größte und wichtigste Fachgesellschaft für Informatik im deutschsprachigen Raum. Es sind ca. 30 Regionalgruppen aktiv. Eine Mitgliedschaft für Studierende entsprechender Fachrichtungen ist kostenlos.

Infos zur Gesellschaft für Informatik

Faust-Edition

Fast zwölf Jahre wurde an der „Historisch-kritischen Edition von Goethes Faust als Hybrid-Ausgabe“ gearbeitet. Das Mammutprojekt wurde von der Universität Würzburg (Projektleitung: Prof. Dr. Anne Bohnenkamp-Renken), der Klassik Stiftung Weimar (Projektleitung: Dr. Silke Henke) und des Frankfurter Goethe-Hauses (Projektleitung: Prof. Dr. Fotis Jannidis) durchgeführt.

Infos zur digitalen Faustedition

Digitale Edition

Eine digitale Edition ist – wie der Name bereits suggeriert – eine Textausgabe, die nicht mehr in Form eines gedruckten, linear zu lesenden Buches vorliegt, sondern als digitale Entität. Dieser Mediumwechsel bringt zahlreiche Veränderungen mit sich – so beispielsweise die Möglichkeit, Wörter oder Textstellen zu ‚taggen‘ oder Transkription und Digitalisat zu verbinden. So befindet sich beispielweise der Verein e-editiones in Gründung, der sich zum Ziel setzt, allgemeine Standards, Austauschmöglichkeiten etc. für die bisher sehr heterogene digitale Editionslandschaft zu entwickeln.

Stilometrie

Die Methode der Stilometrie geht zurück auf das 19. Jahrhundert: Schon damals fragte man sich, ob es individuelle Regelmäßigkeiten gibt, die den Schreibstil von AutorInnen prägen. Der australische Wissenschaftler John Burrows hat sich in den 1980er Jahren auf die 50 häufigsten Wörter konzentriert und bereits ein Autorschaftssignal identifizieren können. Heute sind WissenschaftlerInnen in der Lage, wesentlich mehr Wörter computationell zu verarbeiten und über die Autorschaftsthesen hinauszugehen: So wird der Stil von Epochen oder auch von Gattungen untersucht, Burrows’s Delta ist hierfür ein sehr leistungsfähiges Verfahren.

Introduction to stylometry with Python

Fotis Jannidis / Gerhart Lauer: „Burrows’s Delta and Its Use in German Literary History“ (2014)

Maschinelles Lernen (Machine Learning, Deep Learning)

Maschinelles Lernen heißt, Computer auf die Schulbank zu setzen. Ein lernender Algorithmus baut durch gezieltes Training Stück für Stück ein statistisches Verfahren auf, das mithilfe von Wahrscheinlichkeiten Entscheidungen trifft, so beispielsweise für die Fraktur-Erkennung von OCR-Programmen. Selbstlernende Systeme können eigenständig per Trail and Error richtige Wege finden, neuronale Netze ausbilden und sich damit selbst trainieren (sog. Deep Learning).

TextGrid

TextGrid ist eine Software, die insbesondere die unterstützte Erstellung digitaler Editionen erlaubt. Das Tool umfasst drei wesentliche Module: das ‚Laboratory‘, also die eigentliche Arbeitsumgebung für die editorische Arbeit, das ‚Repository‘, in dem Forschungsdaten langfristig archiviert werden können, und die Anbindung an die ‚Community‘ mit Tutorials und dem Zugang zu Mailinglisten. Das Projekt wurde von 2006 bis 2015 vom Bundesministerium für Bildung und Forschung (BMBF) finanziert. TextGrid ist seit Auslauf der Förderphase Teil der digitalen Forschungsinfrastruktur DARIAH-DE – Digital Research Infrastructure for the Arts and Humanities.

Heike Neuroth u.a. (Hrsg.): TextGrid: Von der Community – für die Community (2015)

Deutsches Textarchiv (DTA)

Das DFG-Projekt Deutsches Textarchiv (DTA) ist an der Berlin-Brandenburgischen Akademie der Wissenschaften beheimatet. Ziel ist, ein digitales wissenschaftliches Referenzkorpus für die neuhochdeutsche Sprache zu entwickeln. Dafür werden Erstausgaben aus dem Zeitraum 1600 bis 1900 digitalisiert, vervolltextet und annotiert. Der Fokus des DTA liegt nicht nur auf kanonischen Texten, sondern auch auf einer breiten Zurverfügungstellung wenig bekannter Textzeugen.

Sentiment-Analyse

Als Sentimentanalyse wird die Untersuchung von Emotionsverläufen in Texten bezeichnet: Mit welchen sprachlichen Mitteln und wie stark werden Gefühle ausgedrückt? Lassen sich in bestimmten Korpora Muster erkennen?

Grounded Theory

Grounded Theory ist eine Methode zur Theoriegenerierung. Traditionellerweise gehen ForscherInnen von einer Theorie aus und prüfen Daten auf diese. Die Grounded Theory dreht den Prozess jedoch um und geht von den Daten aus, um darauf aufbauend eine Theorie zu entwickeln.

Proxy

Ein Proxy oder auch eine Proxy-Variable ist eine Art künstlicher Stellvertreter. Mit ihm lässt sich die semantische Ebene sichtbar und damit untersuchbar machen. Beispielsweise erlaubt die (messbare) Anzahl der Redeanteile weiblicher und männlicher Figuren in Dramen einer bestimmten Epoche indirekt Aussagen über Gender-Aspekte.

Topic Modeling

Topic Modeling ist ein in der Informatik entwickeltes Verfahren, mit dessen Hilfe große Datenmengen erschlossen werden können. Damit können besonders gut Themen aus Sachtexten extrahiert werden, da es auf Grundlage großer Zeitungskorpora entwickelt wurde. Vor der Anwendung der Methode auf literarische Texte muss ein entsprechender, meist auf Zeitungskorpora aufbauender Algorithmus jedoch angepasst werden. Das Topic Modeling basiert auf der Kookkurrenzanalyse: Es wird nach Wörtern gesucht, die überdurchschnittlich häufig gemeinsam auftauchen. Diese Wortpaare oder -gruppen werden in einem zweiten Schritt extrahiert und nach Themen klassifiziert. Im Fall von literarischen Texten sind diese ‚Themen‘ jedoch keine Themen im klassischen Sinne, sondern eher Topoi des Erzählens – beispielsweise das Cluster ‚Wasser, Boot, Brandung‘.

David M. Blei: „Topic Modeling and Digital Humanities“

Kookkurrenzanalyse

Die Kookkurrenzanalyse untersucht das gemeinsame Auftreten von zwei oder mehr lexikalischer Einheiten in einem Text. Sie spielt beispielsweise in der Stilometrie eine Rolle, wenn die Nähe von Einzelwörtern in einem Text untersucht wird, um Rückschlüsse auf den Autorstil zu ziehen.

Tagging / Labeling / Annotieren

Das Wort ‚Tagging‘ bedeutet die Strukturierung von Text, indem Wortgruppen, Einzelwörter oder Wortbestandteile (meist in XML) ausgezeichnet werden. So erhalten beispielsweise Wortarten (bspw. <verb>, Strukturangaben (bspw. <title>) oder Entitäten (bspw. <person>) Labels, die den Ausgangstext maschinenlesbar machen. Die entstehenden strukturierten Daten können nun in anderen Kontexten weiterverwendet werden: So können beispielsweise Figurennetzwerke erstellt oder Register angelegt werden. Die Text Encoding Initiative (TEI) stellt Guidelines bereit, damit WissenschaftlerInnen in die Lage versetzt werden, bei der Auszeichnung von Texten möglichst einheitliche Tag-Sets zu verwenden.

Burrows’s Delta

Burrows’s Delta ist ein Verfahren, das für stilometrische Analysen eingesetzt wird. Es misst die relativen Häufigkeiten der meistverwendeten Wörter eines Autors und erstellt somit dessen ‚Finderabdruck‘. Mit dieser ‚Blaupause‘ der individuellen Wortpräferenzen können dann weitere Texte mit dem Ausgangstext abgeglichen werden. Doch Achtung: Die Ergebnisse drücken die stilometrische Differenz bzw. ein Näheverhältnis (eine sog. Distanzmetrik) zwischen zwei Texten aus – wie nah also Text 1 an Text 2 ist. Falls also ein anonymer Text mit den Profilen von 50 infrage kommenden AutorInnen abgeglichen wird, jedoch der tatsächliche Autor gar kein Bestandteil des Versuchssets war, kann zwar der- oder diejenige AutorIn mit der größten stilistischen Nähe identifiziert werden, doch ist die tatsächliche Urheberschaft damit nicht bewiesen. Ergebnis einer solchen Untersuchung ist daher keine Wahr-/ Falschaussage, sondern immer eine statistische Wahrscheinlichkeit, deren Plausibilität geprüft werden muss.

Digital-Humanities-Stammtisch

An verschiedenen Orten Deutschlands haben sich bereits Digital-Humanities-Stammtische etabliert, so beispielsweise in Berlin, Halle und Mainz. Es gibt sogar einen Twitter-Kanal …

Infos zu DH-Stammtischen in Deutschland

Coding Da Vinci

Coding Da Vinci ist ein Kulturhackathon, der versucht, die produktive Arbeit mit offenen Kulturdaten anzuregen. Ziel ist die Entwicklung spannender Programme, Websites, Visualisierungen etc. Coding Da Vinci wurde 2014 gegründet und ist ein von der Kulturstiftung des Bundes gefördertes Projekt der Deutschen Digitalen Bibliothek, des Forschungs- und Kompetenzzentrums Digitalisierung Berlin, der Open Knowledge Foundation Deutschland und der Wikimedia Deutschland.

Information Retrieval

Information Retrieval ist die Methode, nicht nur nach Einzelwörtern, sondern nach komplexen Inhalten (Texte, Bilddaten etc.) automatisiert zu suchen. Google & Co. sind in dieser Disziplin bekanntlich recht erfolgreich …

Infos zum Information Retrieval

Prof. Ted Underwood

Ted Underwood ist Computerphilologe. Er lehrt sowohl am English Department als auch an der School of Information Sciences an der University of Illinois. Sein Fachgebiet ist insbesondere die Anwendung maschineller Lernverfahren auf große digitale Sammlungen.

Prof. David Bamman

David Bamman lehrt an der University of California (Berkeley). Zu seinen Schwerpunkten gehören Natural Language Processing und Machine Learning.

Natural Language Processing (NLP)

Natural Language Processing bezeichnet die maschinelle Verarbeitung der natürlichen Sprache.

Infos zu Natural Language Processing

Publikationen der Stanford NLP-Group

p-Wert

Der p-Wert ist der Feind des Zufalls. Er misst die Wahrscheinlichkeit, dass ein Ergebnis zufällig entstanden sein könnte.

Embeddings, Word Embeddings

Word Embeddings sind eine Technik des Natural Language Processings (NLP). Damit werden Wörter eines Textkorpus durch natürliche Zahlen ersetzt, um maschinell verarbeitet werden zu können. Doch es ist kein einfacher Austausch: Wörter, die beispielsweise häufig gemeinsam vorkommen, werden durch einen ähnlichen Vektor definiert. Dadurch wird das Einzelwort gewissermaßen multidimensional darstellbar und kann zu anderen Wörtern in Beziehung gesetzt werden. Auch die Kookkurrenzanalyse ist eine Methode, um Word Embeddings zu bestimmen.

Bias

Was ist ein Bias? Nun, wenn du als eingefleischte/r Digital Humanist andere Digital Humanists fragst, ob digitale Forschungsmethoden eine Zukunft haben … dann kannst du ein ziemlich großes Bias oder besser gesagt: eine recht große Voreingenommenheit deiner ProbandInnen erwarten … 😉 Auch Algorithmen können übrigens voreingenommen sein!

Digital Humanities im deutschsprachigen Raum (Dhd)

Der Verband Digital Humanities im deutschsprachigen Raum (Dhd) existiert seit 2013 und führt DH-Interessierte aus Deutschland, Österreich und der Schweiz zusammen. Einmal jährlich findet in einem der drei Länder eine interdisziplinäre Tagung statt.

Deutsche Forschungsgemeinschaft (DFG)

Die Deutsche Forschungsgemeinschaft fördert Forschungsprojekte verschiedenster Disziplinen in Deutschland. Die Förderung mit sogenannten „Drittmitteln“ wird aus Steuergeldern finanziert.

Konkordanzprogramm

Konkordanzprogramme sind Werkzeuge, die einen Text automatisch durchsuchen können. Hiermit kannst du u.a. den Kontext von Wörtern analysieren bzw. mit zuvor definierten Wortlisten ganze Korpora durchsuchen. AntConc ist beispielsweise ein kostenloses Konkordanzprogramm, zu dem es auch YouTube-Tutorials gibt.